Le fichier robots.txt est un fichier texte contenant des instructions pour les robots d’exploration des moteurs de recherche. Ce fichier indique aux robots – également appelés « agents », « crawlers » ou « spiders » – les pages ou les fichiers qu’ils sont autorisés à explorer.

Sommaire

Les fichiers robots.txt sont situés à la racine des sites, dans le répertoire racine d’un domaine. Pour vérifier la présence du fichier robots.txt sur votre site web vous pouvez rechercher dans la barre de recherche de votre navigateur l’adresse :

www.exemple.com/robots.txt

Il s’agit du premier document que les robots ouvrent lorsqu’ils visitent votre site. Vous pouvez également intégrer un lien dans votre fichier robots.txt vers votre sitemap. Le sitemap apporte aux crawlers des moteurs de recherche un aperçu de toutes les URL existantes de votre domaine.

Le fichier sitemap du site se trouve à l’adresse :

https://www.exemple.com/sitemap.xml

Comment fonctionne le fichier robots.txt ?

Tous les robots des moteurs de recherche (user-agents) doivent d’abord rechercher le fichier robots.txt dans le répertoire racine de votre site et lire les instructions qu’il contient.

Ce n’est qu’ensuite que les robots peuvent commencer à indexer votre page web.

Le fichier doit être situé directement dans le répertoire racine de votre domaine et doit être écrit en minuscules (les robots lisent le fichier robots.txt et ses instructions en respectant la minuscule).

Malheureusement, tous les robots des moteurs de recherche ne respectent pas ces règles. Le fichier .txt fonctionne avec les moteurs de recherche les plus importants tels que Bing, Yahoo et Google. Leurs robots suivent strictement les instructions du fichier robots.txt.

En pratique, le fichier robots.txt peut être utilisé pour différents types de fichiers. Si vous l’utilisez pour des fichiers images, il empêche ces fichiers d’apparaître dans les résultats de recherche de Google. Les fichiers de ressources sans importance, tels que les fichiers de script, peuvent également être bloqués facilement avec robots.txt.

En outre, vous pouvez exclure les pages Web générées dynamiquement de l’exploration à l’aide des commandes appropriées, tel que les pages contenant des identifiants de connexion ou des pages paniers d’achats peuvent être bloquées.

Vous pouvez également contrôler l’accès du crawler à d’autres fichiers non-image (pages Web) en utilisant le fichier texte. Ainsi, vous pouvez éviter que :

- Les robots explorent un grand nombre de pages web similaires ou sans importance ;

- Votre budget d’exploration est gaspillé inutilement ;

- Votre serveur est surchargé par les robots d’exploration.

Dans ce contexte, notez toutefois que le fichier robots.txt ne garantit pas que votre site ou des sous-pages ne seront pas indexés. Il ne contrôle que le crawling de votre site, mais pas l’indexation. Si les pages Web ne doivent pas être indexées par les moteurs de recherche, vous devez définir la balise méta suivante dans l’en-tête de votre page web :

<meta name= »robots » content= »noindex »>

Cependant, vous ne devez pas bloquer les fichiers qui sont d’une grande pertinence pour les robots de recherche. Notez que les fichiers CSS et JavaScript doivent également être débloqués, car ils sont utilisés pour l’exploration, notamment par les robots mobiles.

Quelles sont les instructions utilisées dans le fichier robots.txt ?

Votre fichier robots.txt doit être enregistré sous forme de fichier texte UTF-8 ou ASCII dans le répertoire racine de votre page Web.

Il ne doit y avoir qu’un seul fichier portant ce nom. Il contient un ou plusieurs ensembles de règles structurés dans un format clairement lisible. Les règles (instructions) sont traitées de haut en bas en distinguant les majuscules des minuscules.

Que signifient les termes utilisés dans un fichier robots.txt ?

- user-agent : désigne le nom du crawler (les noms peuvent être trouvés dans la base de données des robots)

- disallow : empêche l’exploration de certains fichiers, répertoires ou pages web

- allow : autorise l’exploration de fichiers, de pages Web et de répertoires.

- sitemap (facultatif) : indique l’emplacement du plan du site.

- * : représente un nombre quelconque de caractères

- $ : représente la fin de la ligne

Les instructions du fichier robots.txt se composent toujours de deux parties :

- Définition des robots (user agents) auxquels s’appliquent les instructions ;

- Instructions interdire ou autoriser (disallow / allow).

Exemple : « user-agent : Google-Bot » et l’instruction « disallow : /clients/ » signifient que le robot Google n’est pas autorisé à effectuer des recherches dans le répertoire /clients/.

Si l’ensemble du site web ne doit pas être crawlé par un robot de recherche, l’instruction dans le fichier robots.txt doit être : « user-agent : * » avec l’instruction « disallow : / ».

Vous pouvez utiliser le signe dollar « $ » pour bloquer les pages Web qui ont une certaine extension.

Par exemple : l‘instruction « disallow : /* .doc$ » bloque toutes les URL ayant une extension .doc. De la même manière, vous pouvez bloquer des formats de fichiers spécifiques tel que jpg dans le fichier robots.txt : « disallow : /* .jpg$ ».

Le fichier robots.txt du site web https://www.exemple.fr/ pourrait ressembler à ceci :

User-agent: *

Disallow: /login/

Disallow: /card/

Disallow: /fotos/

Disallow: /temp/

Disallow: /search/

Disallow: /*.pdf$

Sitemap: https://www.example.com/sitemap.xml

Quel rôle joue le fichier robots.txt dans l’optimisation des moteurs de recherche ?

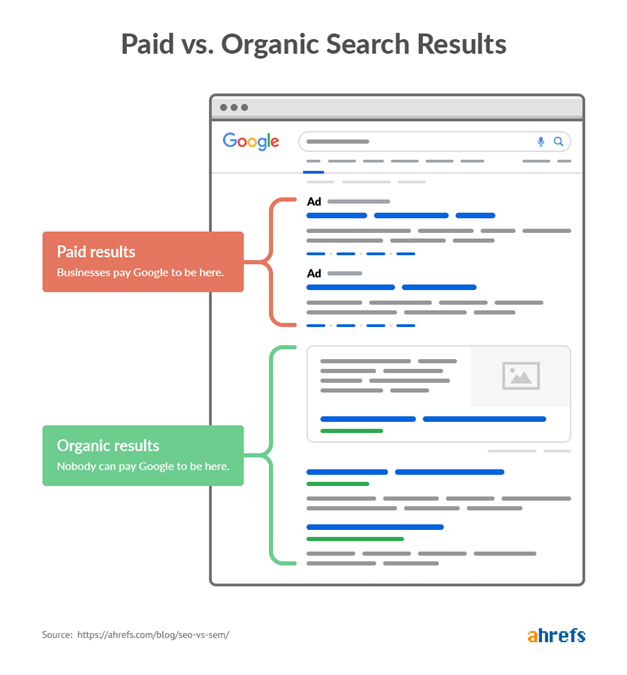

Les instructions contenues dans un fichier robots.txt ont une forte influence sur l’optimisation des moteurs de recherche (SEO), car ce fichier vous permet de contrôler les robots des moteurs de recherche.

Cependant, si les user agents sont trop limités par les instructions disallow, cela a un effet négatif sur le positionnement de votre site web. Vous devez également tenir compte du fait que vous ne serez pas positionné avec des pages Web que vous avez exclues par disallow dans le robots.txt.

Si, par ailleurs, il n’y a pas ou peu de restrictions disallow, il peut arriver que des pages au contenu dupliqué soient indexées, ce qui a également un effet négatif sur le référencement naturel de votre site web.

Avant d’enregistrer le fichier dans le répertoire racine de votre site Web, vous devez en vérifier la syntaxe. Même des erreurs mineures peuvent amener les robots de recherche à ne pas tenir compte des règles d’exclusion et à explorer des sites Web qui ne devraient pas être indexés. De telles erreurs peuvent également avoir pour conséquence que des pages ne soient plus accessibles aux robots de recherche et que des URL entières ne soient pas indexées en raison de la règle disallow.

En utilisant correctement le fichier robots.txt, vous vous assurez que toutes les parties importantes de votre site Web sont explorées par les robots de recherche. . Si aucun fichier robots.txt n’est présent, l’ensemble du contenu de vos pages sera indexé et se retrouvera sur les autres moteurs de recherche.

Finalement, si vous souhaitez pouvoir maitriser l’indexation de votre site web, la création d’un fichier robots.txt s‘avère indispensable.