Vous souhaitez démarrer votre stratégie de référencement sur le bon pied ? Nous proposons un guide des bonnes pratiques qui pourront vous faire gagner ou perdre des points à l’indexation. Avis aux âmes sensibles, cet article peut paraître un peu technique si vous débutez dans le référencement, mais pas de panique, si vous avez besoin d’aide, nous sommes là pour ça (ça tombe bien non ?) !

Sommaire

Comment fonctionne l’indexation ?

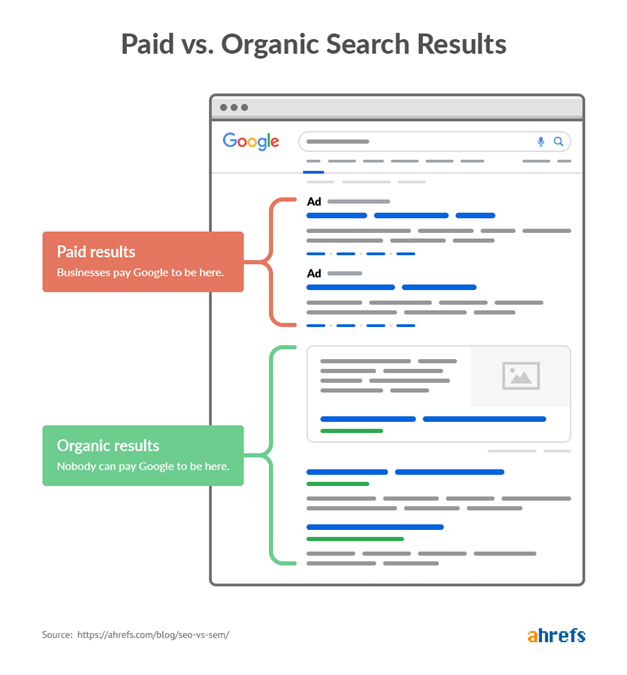

Dans le domaine du référencement naturel, le terme Indexation désigne le fait de classer les sites internet par rapport à leur pertinence sur un sujet donné afin de répondre au mieux aux requêtes des internautes. L’indexation sur les moteurs de recherche est permise par des crawlers c’est-à-dire des algorithmes complexes qui agissent comme des robots et qui visitent les sites pour attribuer une note de pertinence en fonction de nombreux critères divers (technique, sémantique, popularité).

Chaque moteur de recherche à son propre crawler mais le plus connu reste celui de Google (plus de 90% de parts de marché) prénommé GoogleBot. Il existe également des outils/applications (comme Screaming Frog) qui agissent comme des crawlers et qui permettent donc aux entreprises d’analyser leur site de la même façon que le robot d’indexation le ferait.

Attention cependant il faut savoir que le temps de crawl n’est pas illimité (« le temps c’est de l’argent »), chaque site dispose d’un temps défini en fonction de son importance, de la profondeur de son arborescence, etc.) il faut donc veillez à ce que l’algorithme qui visite voie un maximum de page pertinente dans le temps qui lui est imparti. C’est ce qu’on appelle le budget crawl. Si votre site n’est pas bien optimisé, le robot n’évaluera que ce qu’il a eu le temps de voir pendant sa visite ce qui peut être très pénalisant pour votre placement sur la SERP. De plus, il arrive également que l’algorithme ne visite volontairement pas tout le site, parfois ils ne regardent que la page principale ou les pages de premier et second niveau (celles qui changent en général plus souvent et nécessitent une indexation plus régulière).

C’est pourquoi il existe de nombreuses techniques, astuces et vérifications pour « guider » le crawler à être rapide et efficace et ainsi mettre toutes les chances de votre côté. Et vous savez quoi ? C’est précisément ce que l’on a prévu pour vous au programme !

1 – Assurez l’accessibilité du site

Le premier élément auquel vous devez prêter attention est l’accessibilité de votre site c’est-à-dire vérifier s’il est lui-même ainsi que son contenu visible par les moteurs de recherche. Il faut savoir que, bien qu’ils soient très complexes, les crawler restent simples dans leur façon de fonctionner : ils ne peuvent pas remplir de formulaire par eux-mêmes, ni même rentrer de mot de passe. Dès lors que l’accès sera restreint et nécessitera une action de la part de l’internaute, le crawler ne pourra pas accéder au contenu. Par ailleurs, ils n’exécutent pas non plus le langage JavaScript ce qui signifie que si tous vos contenus sont dynamiques (exécutés à l’aide du JS) le robot d’indexation de les verra pas. Mais pas de panique, vous pouvez vérifier cela très facilement par vous-même en téléchargeant sur votre navigateur Chrome l’add-on Web Développer qui vous permettra de désactiver le JavaScript et le CSS ou encore en utilisant le navigateur Lynx (navigateur texte utilisé notamment par les personnes malvoyantes ou les référenceurs pour vérifier le bon fonctionnement du site).

Attention aux erreurs d’exploration 4** et erreurs serveur 5** qui peuvent rendre votre site inaccessible, sur internet vous trouverez facilement la liste des erreurs et leur signification pour les corriger. De plus il faut faire attention aux redirections (code 301 et 302) : elles ne doivent pas être trop nombreuses et une page redirigée ne doit plus être accessible d’aucune autre manière. Par exemple un site en HTTP redirigé en HTTPS doit automatiquement changer l’URL en HTTPS et ne plus être accessible en HTTP (au risque d’avoir le même site dupliqué).

Finalement, prenez le temps de vérifier vos liens (internes ou externes) qui peuvent être cassés s’ils pointent vers une page qui n’existe plus. Un simple check quotidien avec le plug-in Broken Link Checker ne vous fera pas de mal.

2 – Optimisez le temps de chargement

Comme nous l’expliquions ci-dessus le budget de crawl est compté, il faut donc s’assurer que les performances du site permettent d’explorer rapidement un maximum de page. Pour cela, il est nécessaire d’optimiser la vitesse de chargement des pages et des contenus.

Il est très simple de faire une analyse rapide de chez vous grâce à l’outil en ligne gratuit PageSpeed Insight (https://developers.google.com/speed/pagespeed/insights/) qui non seulement attribue une note sur 100, mais donne également des conseils pour améliorer son score. Il existe aussi d’autres outils (tels que Woorank), mais qui sont généralement payants (avec une période d’essai gratuite).

Avant toute chose, assurez-vous que votre hébergement (non non pas votre maison, le serveur !) soit adapté à votre site parce que, bien sûr, le boulanger du coin de la rue n’aura pas besoin des mêmes ressources qu’Amazon (au niveau de la taille du site, de la fréquentation et de nombreux autres facteurs). C’est toute la différence entre serveur mutualisé et serveurs dédiés. (https://www.ionos.fr/digitalguide/hebergement/aspects-techniques/hebergement-mutualise-ou-dedie/).

Une des options pour réduire de façon significative le temps de chargement de votre site est l’utilisation d’un système de cache. Cette technique consiste à enregistrer une partie du site internet dans une mémoire temporaire ou bien dans le disque dur de votre ordinateur afin que le navigateur n’ait pas besoin de charger à nouveau tout le site lors de la prochaine visite (il reprendra les informations déjà contenues dans la « sauvegarde »).

Sur tous les CMS, il existe des plug-ins qui permettent de mettre en place facilement un système de cache. Dans le cas où vous mettriez votre site à jour, sachez qu’il existe sur la grande majorité des plug-ins un système d’invalidation c’est-à-dire qu’en chargeant la page, le navigateur se rendra compte qu’il existe des différences (dans les noms des fichiers système), et il rechargera automatiquement la totalité du site pour mettre à jour les informations dans le cache. Si en revanche vous développez votre site par vous-même il faudra mettre en place ce système de façon manuelle.

Afin de ne pas charger la totalité de la page en une seule fois sachez qu’il est également possible de charger la page en décalée (une information après l’autre) c’est-à-dire de manière asynchrone. Le but de cette optimisation est donc de charger les contenus principaux au début (en HTML), afin que le crawler puisse voir directement les informations pertinentes, et ensuite les contenus secondaires comme les styles CSS, ou bien les contenus embarqués en JavaScript : cartes Google Maps, Google Analytics, animations du site, etc. qui, rappelons-le ne sont pas visibles par le crawler.

La dernière grosse optimisation au niveau du temps de chargement va être la minification des fichiers sources (CSS et JavaScript) et la compression des médias (images, vidéos, etc.).

3 – Guidez le robot d’exploration

Une fois toutes les vérifications réalisées le travail n’est pas fini. En effet, il arrive très souvent que les crawler indexent une grande quantité de pages (dont certaines ne sont pas qualifiées et pénalisent l’indexation), il faut donc se demander si toutes les pages ou contenus du site sont pertinents auquel cas il faut les désindexer s’ils ne peuvent rien apporter de plus. Cette optimisation est permise par le fichier robots.txt. C’est le premier fichier que regarde le robot d’indexation, car il permet de donner des directives de crawl : les pages qui ne sont pas très pertinentes ou bien les fichiers PDF externes ou encore les versions imprimables peuvent-être désindexées grâce à la balise <noindex> ce qui signifie que le crawler n’ira pas les indexer, il pourra ainsi garder son temps de crawl pour les pages principales. Dans ce fichier on peut également retrouver un lien vers le Sitemap c’est-à-dire un schéma de l’arborescence du site qui permet au robot de voir la structure et les pages principales.

L’indexation n’a pas lieu tous les jours, le robot passe de façon aléatoire. Mais il vous est possible de suivre les crawls de votre site et même de soumettre des URL à la file d’attente grâce à la Google Search Console.

Vous êtes arrivés jusqu’ici sans vous perdre (ou presque) ? Félicitations vous connaissez maintenant les principales optimisations techniques à apporter à votre site internet pour briller auprès de GoogleBot.

Pour toutes questions, n’hésitez pas à nous contacter !

Rédigé par Corinne De Langhe